Para lidar com alguns dos grandes desafios gerados pela inteligência artificial, como fake news e desinformação, a empresa começa a testar ferramenta que sinaliza manipulação por máquinas

O Google anunciou uma ferramenta, ainda em teste, que identifica conteúdo criado por inteligência artificial. A SynthID, do Google Cloud, divisão de nuvem da empresa, adiciona uma marca d’água nas imagens feitas a partir de IA generativa, a mesma que roda em apps como MidJourney e DALL-E, os mais utilizados para esse tipo de finalidade.

“Embora a IA generativa possa desbloquear um enorme potencial criativo, também apresenta novos riscos, como permitir que os criadores divulguem informações falsas – intencionalmente ou não. Ser capaz de identificar conteúdo gerado por IA é fundamental para capacitar as pessoas com conhecimento de quando estão interagindo com a mídia gerada e para ajudar a prevenir a propagação de desinformação”, afirmou a empresa, em seu blog.

Como o Google vai identificar conteúdo de IA:

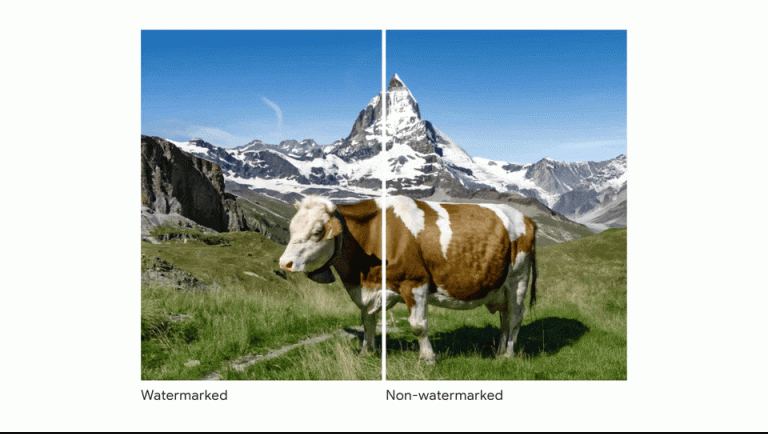

O sistema mapeia, por meio da leitura de pixels, imagens que foram geradas por máquinas e aplica uma identificação não visível a olho nu.

A sinalização é visível apenas por algoritmos, ou seja, ela não altera a qualidade das imagens. A mesma ferramenta também rastreia e identifica se houve algum tipo de alteração por máquinas. O lançamento da SynthID foi feito por meio de um post no blog oficial do Google, na terça-feira, 29.

“O SynthID está sendo lançado para um número limitado de clientes que usam a ferramenta Imagen, um de nossos mais recentes modelos de texto para imagem que usa texto de entrada para criar imagens fotorrealistas”, diz a empresa.

Por que isso é importante?

Apesar de ainda estar disponível de forma restrita, o anúncio dessa ferramenta é emblemático e importante diante das discussões sobre produções feitas a partir de IA generativa. No dia 21 de julho, um grupo de empresas que atuam com IA direta ou indiretamente, entre elas o Google, anunciou esforço conjunto e um compromisso com a Casa Branca para identificar conteúdo feito através de IA.

Além da Alphabet, holding do Google, o grupo inclui Meta e a OpenAI, dona do ChatGPT. As empresas se comprometeram a testar minuciosamente os sistemas antes de lançá-los e compartilharem informações sobre como reduzir os riscos e investir em segurança digital.

Existem algumas formas de testar este tipo de conteúdo: análise de linguagem, análise visual e análise de comportamento. A ferramenta anunciada pelo Google atua nas duas primeiras frentes. Além dessas tecnologias, Google, Meta, OpenAI e CIA também estão trabalhando em maneiras de rastrear e identificar os criadores de conteúdo criado por IA. Isso pode ajudar a responsabilizar os criadores desse conteúdo por suas ações.

Combate a fake news e desinformação

Em 30 de março, o MidJourney encerrou um período de testes gratuitos após a repercussão de uma foto do Papa criada em seus sistemas. Na ocasião, o pontífice aparecia vestindo uma blusa de grife. A imagem foi, inicialmente, identificada como real até mesmo por veículos de imprensa. Ainda que não tenha associado o fim dos testes com o ocorrido, a ferramenta afirmou que precisa aprimorar as formas de identificar o conteúdo que os usuários geram através de suas tecnologias.

O que é inteligência artificial generativa?

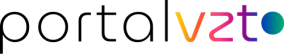

A inteligência artificial generativa é uma tecnologia que permite que um computador crie conteúdo, como texto, imagens, música ou até mesmo vídeos. Ao contrário da inteligência artificial convencional, que é programada para executar tarefas específicas, a IA generativa é capaz de criar algo novo e inesperado. Essa tecnologia é baseada em algoritmos de aprendizado de máquina que são treinados usando enormes conjuntos de dados. Por exemplo, um algoritmo de aprendizado de máquina pode ser treinado usando milhões de imagens de gatos, o que permite que ele crie suas próprias imagens de gatos.

A IA generativa já está sendo usada em diversas áreas, como na criação de novos produtos de beleza, na produção de arte e até mesmo na criação de roteiros de filmes. Um dos exemplos mais famosos é o programa DeepDream, criado pelo Google, que usa IA generativa para criar imagens psicodélicas a partir de fotos.

Apesar das possibilidades oferecidas pela IA generativa, há também preocupações éticas em torno do seu uso. Por exemplo, se um programa de IA generativo escreve uma notícia falsa que é indistinguível da realidade, isso pode ter consequências graves para a sociedade.

Assista ao vídeo que explica como o Google vai identificar conteúdo gerado por IA (em inglês):

Fonte: Forbes